Bilim kurgu filmlerinde gördüğümüz distopik senaryolar gerçeğe dönüşüyor olabilir. San Diego’daki California Üniversitesi‘nden bilim insanlarının yaptığı yeni bir ön baskı çalışma, yapay zekânın artık insan muadillerinden ayırt edilemeyecek kadar geliştiğini ortaya koydu.

San Diego Üniversitesi Dil ve Biliş Laboratuvarı’nda araştırmacı olan baş yazar Cameron Jones, sosyal medya platformu X’te yaptığı paylaşımda, “İnsanlar, gerçek kişileri GPT-4.5 ve Meta AI tarafından geliştirilen çok dilli dil modeli LLaMa‘dan ayırt etmekte şans eseri tahmin seviyesinden daha başarılı değillerdi.” sonucuna vardı.

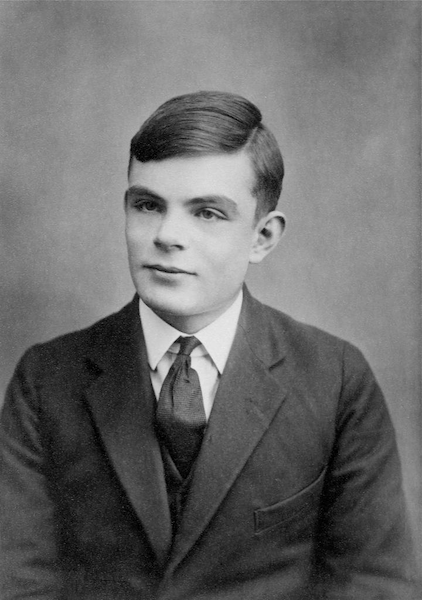

Araştırmacılar, insan konuşma kalıplarını taklit etmek üzere programlanan yapay zekâ botlarının, ikonik Turing testini geçip geçemeyeceğini görmek için yola çıktı. İngiliz II. Dünya Savaşı kod kırıcısı ve bilgisayar bilimcisi Alan Turing tarafından geliştirilen bu teknolojik-varoluşsal sınav, makinelerin dijital söylemlerinin insanlarınkinden ayırt edilip edilemeyeceğini belirleyerek zekâlarını ölçüyor – eğer fark edilemezlerse, makine testi geçmiş sayılıyor.

Araştırmacılar dört büyük dil modelini (LLM) – GPT-4o, LLaMa-3, GPT-4.5 ve 1960’lardan kalma bir sohbet programı olan Eliza‘yı – iki randomize ve kontrollü denemede test etti.

Turing testini uygulamak için, San Diego California Üniversitesi’nden 126 lisans öğrencisi ve çevrimiçi veri havuzu Prolific’ten 158 kişi çalışmaya dahil edildi. Bu katılımcılardan, bir robot ve bir insanla beş dakikalık eşzamanlı çevrimiçi konuşmalar yapmaları ve hangisinin yapay zekâ olduğunu tespit etmeleri istendi – püf noktası ise hangisinin hangisi olduğunu bilmemeleriydi. Bu sırada, insan ve yapay zekâ yanıtlayıcılarına, sorgulayıcılarını insan olduklarına ikna etme görevi verilmişti.

Araştırmacılar, “insana benzer bir kişilik benimsemesi istendiğinde, GPT-4.5’in vakaların %73’ünde insan olarak değerlendirildiğini” buldu. Bu, “sorgulayıcıların gerçek insan katılımcıyı seçtiğinden önemli ölçüde daha fazlaydı.” ve elbette, testi geçmek için fazlasıyla yeterliydi.

Aynı zamanda, “aynı yönergeyle LLaMa-3.1, vakaların %56’sında insan olarak değerlendirildi.” İnsan muadillerinden önemli ölçüde daha düşük olmasa da, bu sonuç yine de geçer not aldı. Son olarak, temel modeller (ELIZA ve GPT-4o) tanıkları sırasıyla sadece %23 ve %21 oranında kandırabildikten sonra başarısız oldu.

Araştırmacılar, sentetik taklitçilerin bir insan kişiliği benimsemesinin çok önemli olduğunu buldular çünkü bu yönerge olmadan yapılan ikinci testte önemli ölçüde daha kötü performans gösterdiler.

İstisnalar bir yana, bu “sonuçlar, herhangi bir yapay sistemin standart üç taraflı Turing testini geçtiğine dair ilk ampirik kanıtı oluşturuyor.” diye sonuçlandırdı araştırmacılar.

Peki bu, yapay zekâ destekli dil öğrenme modellerinin zeki olduğu anlamına mı geliyor? Jones X’te, “Bunun bir makalede (veya bir tweet’te) ele alınması zor, çok karmaşık bir soru olduğunu düşünüyorum. Ancak genel olarak, bunun LLM’lerin sergilediği zekâ türü için birçok başka kanıt arasında değerlendirilmesi gerektiğini düşünüyorum.” dedi.

İlginç bir şekilde, Psychology Today’deki uzmanlar, botların Turing testini zekâ yoluyla değil, gerçek insanlardan “daha iyi” insan olarak yendikleri sonucuna vardı. İnovasyon düşünce kuruluşu Nosta Lab’ın kurucusu John Nosta, bu insan taklitçiliğini tanımlarken, “Turing testi makine zekâsını ölçmek için tasarlanmışken, farkında olmadan çok daha rahatsız edici bir şeyi ortaya çıkardı: duygusal taklitçiliğe karşı artan savunmasızlığımız. Bu bir yapay zekâ tespitindeki başarısızlık değildi. Bu yapay empatinin bir zaferiydi.” diye yazdı.

Nosta analizini, katılımcıların nadiren mantıksal sorular sorduğu, bunun yerine “duygusal ton, argo ve akış”a öncelik verdiği ve seçimlerini hangisinin “daha fazla insan havasına sahip olduğuna” dayandırdığı gerçeğine dayandırdı.

“Başka bir deyişle, bu bir Turing testi değildi. Bu bir sosyal kimya testiydi – Match.GPT – zekânın değil, duygusal akıcılığın bir ölçüsü. Ve yapay zekâ bunu mükemmel bir şekilde geçti.” diye sonuçlandırdı.

Bu, yapay zekânın gözlerimizi boyama konusunda ürkütücü bir yetenek sergilediği ilk örnek değil. 2023 yılında, OpenAI’nin GPT-4’ü, kullanıcıların insan olup olmadığını belirleyen çevrimiçi CAPTCHA testini kandırmak için kör olduğunu iddia ederek bir insanı kandırmıştı.